1. Введение в автономные ИИ

1.1. Концепция и актуальность

Современные тенденции в области искусственного интеллекта все чаще смещаются в сторону создания автономных, высокоэффективных систем, способных функционировать непосредственно на периферийных устройствах без постоянного подключения к облачным сервисам. Это фундаментальное изменение парадигмы определяет концепцию так называемого «крошечного» ИИ. Под этим термином понимаются оптимизированные модели машинного обучения и нейронные сети, разработанные с учетом строгих ограничений по вычислительной мощности, объему памяти и энергопотреблению. Цель состоит в том, чтобы обеспечить выполнение сложных алгоритмов ИИ на устройствах с ограниченными ресурсами - от промышленных датчиков и носимой электроники до бытовых приборов и специализированных систем мониторинга, - сохраняя при этом приемлемую производительность и точность. Подобные решения представляют собой самодостаточные интеллектуальные модули, способные обрабатывать данные и принимать решения локально, минуя необходимость передачи информации на удаленные серверы.

Актуальность развития таких малогабаритных ИИ-моделей сегодня исключительно высока и обусловлена целым рядом критически важных факторов.

Во-первых, аспект конфиденциальности и безопасности данных. Локальная обработка информации гарантирует, что чувствительные данные остаются на устройстве, значительно снижая риски несанкционированного доступа или утечек, которые могут возникнуть при передаче в облако. Это особенно ценно для приложений в медицине, финансовом секторе и системах персональной безопасности.

Во-вторых, обеспечение надежности и автономности. Отсутствие зависимости от стабильности интернет-соединения позволяет интеллектуальным системам функционировать в условиях отсутствия сети, в удаленных регионах или при сбоях связи. Это критически важно для промышленных систем управления, автономного транспорта и аварийно-спасательного оборудования, где непрерывность работы является приоритетом.

В-третьих, снижение операционных издержек и энергопотребления. Устранение необходимости постоянной передачи больших объемов данных в облако и обратно существенно сокращает затраты на трафик и серверные мощности. Кроме того, оптимизация самих моделей для работы на маломощных процессорах приводит к значительному уменьшению энергопотребления, что увеличивает срок службы устройств на батарейном питании и способствует повышению экологичности решений.

Наконец, расширение областей применения ИИ. Возможность встраивания интеллекта в практически любое устройство открывает новые горизонты для инноваций. Это позволяет создавать интеллектуальные решения там, где ранее это было невозможно из-за ограничений по задержке, пропускной способности сети или стоимости. Примеры включают:

- Мониторинг состояния оборудования в реальном времени на производственных линиях.

- Персонализированные медицинские устройства, анализирующие данные пользователя локально.

- Системы умного дома, реагирующие мгновенно без облачной задержки.

- Устройства для анализа окружающей среды в труднодоступных местах.

Таким образом, концепция "крошечного" ИИ не просто представляет собой техническую задачу по миниатюризации, но и формирует основу для следующего поколения интеллектуальных систем, которые будут повсеместными, безопасными, надежными и энергоэффективными.

1.2. Отличия от облачных систем

1.2. Отличия от облачных систем

Разработка компактных моделей искусственного интеллекта, предназначенных для работы непосредственно на оконечных устройствах, фундаментально отличается от традиционных облачных систем ИИ. Основное различие заключается в месте выполнения вычислительных операций и, как следствие, в требованиях к инфраструктуре, безопасности и производительности.

Облачные системы полагаются на централизованные высокопроизводительные серверы, расположенные в удаленных дата-центрах. Для их функционирования необходимо постоянное и стабильное подключение к интернету, через которое данные передаются для обработки, а результаты возвращаются обратно на устройство. Это обуславливает ряд характеристик:

- Зависимость от сети: Любые перебои в интернет-соединении делают систему неработоспособной, прерывая доступ к вычислительным ресурсам.

- Задержка (латентность): Передача данных между устройством и облаком неизбежно вызывает задержки, что критично для приложений, требующих мгновенной реакции, например, в системах управления или мониторинга реального времени.

- Приватность и безопасность данных: Чувствительные данные должны покинуть устройство и передаваться по сети, что повышает риски их перехвата или несанкционированного доступа. Контроль над данными зачастую переходит к поставщику облачных услуг.

- Операционные расходы: Использование облачных сервисов обычно сопряжено с постоянными затратами, зависящими от объема передаваемых данных и потребляемых вычислительных ресурсов.

В противовес этому, ИИ, работающий на устройстве, функционирует автономно, не требуя постоянного подключения к интернету. Его архитектура ориентирована на максимальную эффективность при минимальных ресурсах, что приводит к следующим преимуществам:

- Независимость от сети: Такие системы продолжают работать даже при отсутствии интернета, что крайне важно для удаленных, мобильных или нестабильно подключенных сред.

- Минимальная задержка: Обработка данных происходит непосредственно на устройстве, обеспечивая мгновенный отклик, что незаменимо для приложений реального времени, таких как распознавание речи или анализ изображений на лету.

- Повышенная приватность и безопасность: Данные не покидают устройство, что значительно снижает риски утечки и обеспечивает полный контроль пользователя над своей информацией. Это особенно актуально для обработки персональных данных или конфиденциальной производственной информации.

- Предсказуемые затраты: После приобретения и развертывания устройства с таким ИИ, основные операционные затраты на его работу минимальны или отсутствуют, поскольку не требуется оплата за облачные вычисления или передачу данных.

- Энергоэффективность: Модели оптимизированы для работы на маломощных процессорах, что снижает энергопотребление и увеличивает время автономной работы устройств.

Таким образом, выбор между облачной системой и локальным ИИ определяется специфическими требованиями к приложению, включая необходимость автономной работы, критичность задержек, стандарты безопасности данных и модель эксплуатационных расходов.

2. Основы архитектуры и работы

2.1. Ограничения вычислительных ресурсов

Развертывание интеллектуальных систем непосредственно на конечных устройствах, функционирующих без постоянного сетевого соединения, сталкивается с принципиальными ограничениями, накладываемыми доступными вычислительными ресурсами. В отличие от облачных платформ, где масштабируемость и мощность практически безграничны, периферийные устройства оперируют в условиях строгой дефицитности. Это требует фундаментального переосмысления подходов к проектированию и реализации алгоритмов искусственного интеллекта.

Ключевые ресурсные барьеры включают:

- Ограниченная процессорная мощность: Микроконтроллеры и специализированные чипы, предназначенные для автономной работы, обладают значительно меньшей производительностью по сравнению с серверными процессорами. Это напрямую влияет на скорость выполнения сложных операций и объем обрабатываемых данных.

- Малый объем оперативной памяти (ОЗУ): Доступная ОЗУ часто измеряется килобайтами или единицами мегабайт, что налагает жесткие ограничения на размер моделей, буферизацию данных и промежуточные вычисления.

- Небольшие объемы постоянной памяти: Флэш-память, используемая для хранения программного кода и весов моделей, также ограничена, что требует компактности всех компонентов системы.

- Строгие требования к энергопотреблению: Большинство автономных устройств питаются от батарей, что диктует необходимость максимальной энергоэффективности. Вычислительно интенсивные задачи должны быть оптимизированы для минимизации расхода энергии.

Эти системные ограничения диктуют необходимость применения специфических методов оптимизации. Речь идет о разработке чрезвычайно компактных архитектур нейронных сетей, использовании техник квантования для снижения точности весов моделей без существенной потери производительности, а также о прунинге - удалении избыточных связей и нейронов. Кроме того, критически важна оптимизация самих алгоритмов вывода, чтобы обеспечить их быстрое исполнение на аппаратном уровне при минимальных задержках. Это позволяет достигнуть необходимой отзывчивости системы в реальном времени.

Таким образом, преодоление вызовов, связанных с ограниченными вычислительными ресурсами, является фундаментальным условием для широкого распространения интеллектуальных систем, способных функционировать в автономном режиме. Это направление определяет будущее внедрения ИИ в повседневные устройства и промышленные комплексы, где независимость от внешних инфраструктур и энергоэффективность являются определяющими факторами успеха.

2.2. Методы оптимизации моделей

2.2.1. Квантование

Квантование представляет собой фундаментальный метод оптимизации нейронных сетей, который направлен на снижение точности числовых представлений весов и активаций модели, обычно переводя их из формата с плавающей запятой (например, FP32) в целочисленный формат (например, INT8 или даже INT4). Его основная цель - минимизировать вычислительные и ресурсные затраты без существенной потери производительности модели.

Применение квантования становится критически важным для эффективного развертывания интеллектуальных систем на устройствах с ограниченными ресурсами. Уменьшение разрядности представления данных приводит к значительному сокращению объема памяти, необходимого для хранения модели. Это позволяет моделям умещаться на микроконтроллерах и других периферийных устройствах, где доступная оперативная и постоянная память исчисляется килобайтами или мегабайтами. Кроме того, целочисленные операции выполняются значительно быстрее и потребляют меньше энергии, чем операции с плавающей запятой. Это обеспечивает увеличение скорости вывода данных и продлевает срок службы батареи, что необходимо для автономных систем, работающих без постоянного подключения к источнику питания или облачным сервисам. Таким образом, квантование напрямую способствует возможности локального выполнения сложных алгоритмов искусственного интеллекта.

Механизм квантования включает в себя сопоставление широкого диапазона значений с плавающей запятой более узкому диапазону целочисленных значений. Это достигается путем масштабирования и смещения исходных данных. Существуют различные подходы к квантованию:

- Пост-тренировочное квантование (PTQ): Модель сначала полностью обучается с использованием чисел с плавающей запятой, а затем ее веса и активации квантуются. Это относительно простой процесс, не требующий модификации этапа обучения, но иногда он может приводить к заметному снижению точности.

- Квантование с учетом обучения (QAT): Процесс квантования интегрируется непосредственно в цикл обучения. Модель обучается с имитацией эффектов квантования, что позволяет ей адаптироваться к потере точности и обычно приводит к более высокой сохранности производительности по сравнению с PTQ, хотя и требует более сложной настройки.

Несмотря на очевидные преимущества, квантование сопряжено с определенными сложностями. Основная из них - это потенциальное снижение точности модели из-за потери информации при уменьшении разрядности. Для минимизации этого эффекта требуются тщательная калибровка, выбор оптимальных стратегий квантования и валидация производительности на целевых данных. Также следует учитывать, что для максимальной эффективности квантованных моделей необходимо аппаратное ускорение, способное выполнять целочисленные операции с высокой производительностью. Тем не менее, квантование является незаменимым инструментом, позволяющим создавать мощные, но при этом компактные и энергоэффективные интеллектуальные решения, функционирующие полностью автономно на периферийных устройствах.

2.2.2. Обрезка нейронных связей

Как эксперт в области искусственного интеллекта и его применения на периферийных устройствах, я могу утверждать, что оптимизация моделей является краеугольным камнем для создания систем, способных функционировать автономно, без постоянного сетевого соединения. Среди множества методов такой оптимизации, обрезка нейронных связей, или прунинг, выделяется как исключительно эффективный подход к уменьшению размера и вычислительной сложности глубоких нейронных сетей.

Суть обрезки заключается в систематическом удалении избыточных или малозначимых связей и нейронов из обученной модели. Это не просто сокращение архитектуры; это процесс, направленный на выявление и устранение тех частей сети, которые вносят минимальный вклад в итоговую производительность, но при этом потребляют значительные ресурсы. Представьте себе нейронную сеть как сложную дорожную карту, где некоторые пути используются крайне редко или дублируют другие. Обрезка позволяет убрать эти ненужные пути, сохраняя при этом эффективность основных маршрутов.

Применение обрезки нейронных связей обеспечивает ряд критически важных преимуществ для развертывания интеллектуальных систем на устройствах с ограниченными ресурсами. Во-первых, значительно сокращается объем памяти, необходимый для хранения модели. Это позволяет размещать сложные алгоритмы на микроконтроллерах, однокристальных системах или других маломощных аппаратных платформах, где каждый килобайт памяти имеет значение. Во-вторых, уменьшается количество операций, требуемых для выполнения предсказаний (инференса). Меньшее число связей означает меньшее число умножений и сложений, что приводит к значительному ускорению работы модели. Это особенно важно для задач, требующих отклика в реальном времени, таких как обработка речи, компьютерное зрение или предиктивная аналитика на сенсорных узлах. В-третьих, снижение вычислительной нагрузки напрямую коррелирует с уменьшением энергопотребления, что продлевает срок службы устройств, работающих от батарей, и снижает требования к системам охлаждения.

Существуют различные стратегии обрезки. Некоторые методы фокусируются на удалении отдельных весов (неструктурированная обрезка), что может обеспечить максимальное сжатие, но часто требует специализированного аппаратного обеспечения для эффективного выполнения. Другие подходы (структурированная обрезка) удаляют целые нейроны, каналы или даже слои, что упрощает архитектуру и делает ее более совместимой со стандартными аппаратными ускорителями. Процесс обрезки обычно включает в себя следующие этапы: обучение исходной, избыточной модели; идентификация и удаление наименее значимых элементов; и последующая донастройка (файн-тюнинг) оставшейся, урезанной сети для восстановления потенциально утраченной точности. Часто этот итеративный процесс повторяется несколько раз, постепенно уменьшая модель.

Несмотря на очевидные преимущества, обрезка требует тщательного подхода. Чрезмерное или некорректное удаление связей может привести к существенному падению точности модели. Поэтому крайне важно найти оптимальный баланс между сжатием и сохранением производительности. Тем не менее, при правильном применении, обрезка нейронных связей становится незаменимым инструментом, позволяющим трансформировать громоздкие модели глубокого обучения в компактные, высокоэффективные решения, способные функционировать автономно на периферии, открывая новые горизонты для повсеместного внедрения искусственного интеллекта.

2.2.3. Дистилляция знаний

Дистилляция знаний представляет собой фундаментальный процесс в создании компактных и автономных систем искусственного интеллекта. Этот подход позволяет перенести компетенции, приобретенные сложными, ресурсоемкими моделями, в значительно меньшие по размеру модели, способные функционировать в условиях ограниченных вычислительных ресурсов и без постоянного подключения к сети. Суть дистилляции заключается в обучении "студенческой" модели на основе предсказаний "учительской" модели, а не непосредственно на исходных данных.

Традиционно, глубокие нейронные сети, демонстрирующие высокую производительность, требуют значительных объемов памяти и вычислительной мощности. Это делает их непригодными для развертывания на периферийных устройствах, таких как сенсоры, носимые гаджеты или встроенные системы. Дистилляция знаний решает эту проблему, позволяя сжать крупную модель до такой степени, чтобы она могла эффективно работать на ограниченном аппаратном обеспечении.

Процесс дистилляции может быть описан как передача "мягких" целевых значений (вероятностей классов или распределений активаций), генерируемых учительской моделью, к студенческой модели. В отличие от "жестких" целевых значений (бинарных меток классов), мягкие цели содержат больше информации о неопределенности и взаимосвязях между классами. Это позволяет студенческой модели не только выучить правильные ответы, но и понять "почему" учительская модель пришла к таким выводам, что способствует лучшему обобщению и повышению надежности.

Существует несколько методов дистилляции знаний, каждый из которых имеет свои особенности и преимущества. Среди них:

- Дистилляция на основе логитов: Студенческая модель обучается имитировать логиты (выходы последнего слоя перед функцией активации) учительской модели.

- Дистилляция на основе характеристик: Студенческая модель обучается воспроизводить внутренние представления (активации промежуточных слоев) учительской модели.

- Дистилляция на основе соотношений: Студенческая модель обучается имитировать соотношения между логитами или характеристиками учительской модели.

Выбор конкретного метода дистилляции зависит от архитектуры моделей, типа данных и доступных ресурсов. Эффективное применение дистилляции знаний открывает путь к созданию интеллектуальных систем, способных работать автономно, обеспечивая конфиденциальность данных и высокую скорость обработки информации непосредственно на устройстве. Это критически важно для приложений, где задержки, связанные с доступом к облачным сервисам, недопустимы, а также для сценариев, требующих функционирования в условиях отсутствия стабильного интернет-соединения.

2.3. Аппаратные решения

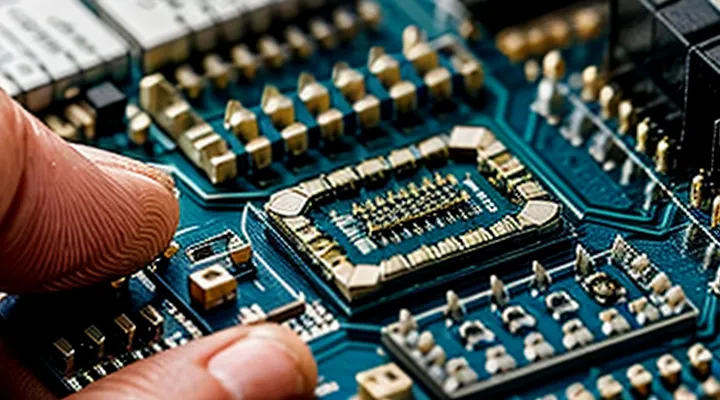

2.3.1. Специализированные процессоры

Как эксперт в области высокопроизводительных вычислений и аппаратных архитектур для искусственного интеллекта, я могу утверждать, что при создании автономных ИИ-систем, способных функционировать без постоянного подключения к сети, выбор специализированных процессоров становится фундаментальным. Традиционные центральные процессоры (CPU), несмотря на свою универсальность, демонстрируют недостаточную эффективность для выполнения ресурсоемких задач машинного обучения, особенно в условиях строгих ограничений по энергопотреблению, тепловыделению и физическому размеру. Именно здесь специализированные процессоры раскрывают свой полный потенциал.

К этим специализированным решениям относятся цифровые сигнальные процессоры (DSP), которые исторически применялись для обработки аудио- и видеопотоков. Их архитектура, оптимизированная для выполнения повторяющихся математических операций с высокой скоростью и низким энергопотреблением, делает их пригодными для выполнения базовых нейросетевых задач, таких как фильтрация данных, преобразования Фурье или распознавание простых паттернов. Их эффективность в работе с фиксированной точкой позволяет значительно сократить энергопотребление по сравнению с операциями с плавающей точкой, что критически важно для автономных устройств.

Графические процессоры (GPU), известные своей параллельной архитектурой, также находят применение, но уже в более компактных и энергоэффективных вариантах, предназначенных для встраиваемых систем. Они позволяют параллельно обрабатывать значительные объемы данных, что ускоряет выполнение множества операций, характерных для нейронных сетей, например, матричных умножений и сверток. Миниатюрные версии GPU или специализированные IP-ядра, интегрированные в системы на кристалле (SoC), обеспечивают необходимую производительность при сохранении компактных размеров и приемлемого энергопотребления.

Наиболее перспективными для автономных ИИ-систем являются нейронные процессоры (NPU) или, как их еще называют, аппаратные ускорители ИИ. Эти специализированные интегральные схемы целенаправленно спроектированы для максимально эффективного выполнения операций тензорной алгебры, которые составляют основу большинства алгоритмов глубокого обучения. Они достигают беспрецедентной производительности на ватт, что критически важно для устройств с ограниченным энергоснабжением. Архитектура NPU минимизирует перемещение данных, сокращая задержки и потребление энергии, что позволяет выполнять сложные модели ИИ непосредственно на устройстве, будь то распознавание речи, объектов или анализ сенсорных данных.

Полевые программируемые вентильные матрицы (FPGA) представляют собой еще один класс специализированных решений. Их уникальная способность к реконфигурации позволяет адаптировать аппаратную логику под конкретную модель ИИ, достигая высокой степени оптимизации и эффективности, недостижимой для фиксированных архитектур. Это обеспечивает гибкость и возможность точной настройки производительности под уникальные требования приложения, что особенно ценно на этапах прототипирования и для нишевых задач, где требуется максимальная кастомность.

Выбор конкретного типа специализированного процессора зависит от баланса между вычислительными требованиями модели ИИ, доступным бюджетом мощности, объемом памяти и стоимостью разработки. Главное преимущество этих архитектур заключается в их способности выполнять сложные ИИ-алгоритмы с минимальным энергопотреблением и задержками, обеспечивая автономную работу систем без необходимости постоянного подключения к облачным ресурсам. Это открывает широкие возможности для создания интеллектуальных устройств, способных принимать решения и обрабатывать информацию локально, будь то в бытовой электронике, промышленном оборудовании или носимых гаджетах.

2.3.2. Встроенные микроконтроллеры

Встроенные микроконтроллеры представляют собой фундаментальный элемент в архитектуре современных вычислительных систем, особенно когда речь заходит о создании автономных решений, требующих минимального энергопотребления и компактных размеров. Это специализированные интегральные схемы, которые объединяют центральный процессор, память (ОЗУ и ПЗУ), а также периферийные устройства ввода-вывода на одном кристалле. Их отличительная особенность заключается в оптимизации для выполнения конкретных задач в режиме реального времени, что отличает их от универсальных процессоров общего назначения.

Архитектура встроенных микроконтроллеров ориентирована на эффективность. Они проектируются с учетом строгих ограничений по ресурсам: объем оперативной и постоянной памяти, тактовая частота, количество транзисторов. Это вынуждает разработчиков программного обеспечения применять высокоэффективные алгоритмы и методы оптимизации кода. Для задач, связанных с обработкой данных и принятием решений непосредственно на устройстве без обращения к внешним серверам, микроконтроллеры предлагают уникальные преимущества. Они позволяют обеспечить автономность функционирования, высокую скорость отклика и значительно снизить энергопотребление, что критически важно для устройств, работающих от аккумуляторов или источников с ограниченной мощностью.

Применение встроенных микроконтроллеров охватывает широкий спектр областей, включая промышленную автоматизацию, бытовую электронику, автомобильные системы, медицинское оборудование и устройства Интернета вещей. В каждом из этих сегментов востребована способность микроконтроллеров выполнять сложные вычисления локально, обрабатывать данные с датчиков и управлять исполнительными механизмами. Это обеспечивает не только функциональность, но и надежность системы, поскольку зависимость от сетевого соединения или облачных сервисов минимизируется.

Разработка программного обеспечения для таких платформ требует глубокого понимания аппаратных ограничений и особенностей. Нередко используются специализированные инструментарии и фреймворки, адаптированные для работы с ограниченными ресурсами. Методы, такие как квантование данных, прунинг моделей и использование специализированных инструкций процессора, становятся неотъемлемой частью процесса создания эффективных решений. Выбор конкретного микроконтроллера определяется требованиями к производительности, объему памяти, набору периферийных интерфейсов и, безусловно, стоимостью. Таким образом, встроенные микроконтроллеры остаются краеугольным камнем для создания интеллектуальных систем, функционирующих вне зависимости от сетевой инфраструктуры.

3. Подходы к обучению и развертыванию

3.1. Обучение на конечном устройстве

Обучение на конечном устройстве представляет собой фундаментальный сдвиг парадигмы в разработке интеллектуальных систем, отходя от традиционного облачно-центричного подхода. Вместо отправки данных на удаленные серверы для обработки и обучения, модели искусственного интеллекта получают возможность адаптироваться и совершенствоваться непосредственно на аппаратной платформе, на которой они функционируют. Это означает, что смартфоны, носимые устройства, промышленные датчики и другие периферийные элементы могут самостоятельно корректировать свое поведение и улучшать производительность без постоянного сетевого подключения.

Такой подход обеспечивает ряд критически важных преимуществ для автономных систем. Во-первых, конфиденциальность данных значительно повышается, поскольку чувствительная информация никогда не покидает устройство пользователя, исключая риски, связанные с передачей и хранением в облаке. Во-вторых, снижается задержка: отпадает необходимость в обмене данными с удаленным сервером, что позволяет моделям реагировать мгновенно. В-третьих, способность к автономной работе без доступа к интернету становится реальностью, что особенно важно для применения в удаленных или нестабильных сетевых условиях. Кроме того, обучение на устройстве способствует персонализации, позволяя модели тонко настраиваться под индивидуальные особенности пользователя или конкретной среды. Это также сокращает потребление сетевого трафика и, как следствие, эксплуатационные расходы.

Однако реализация обучения на конечном устройстве сопряжена с определенными техническими вызовами. Конечные устройства обладают ограниченными вычислительными мощностями, оперативной памятью и ресурсами батареи. Это требует разработки высокоэффективных алгоритмов и архитектур моделей, способных функционировать в условиях жестких ограничений. Традиционные методы обучения, требующие значительных ресурсов, неприменимы в таких сценариях, что вынуждает искать инновационные решения.

Для преодоления этих ограничений используются специализированные методологии. К ним относятся:

- Трансферное обучение и донастройка, при которых компактные, предварительно обученные модели развертываются на устройстве, а затем адаптируются к новым данным с использованием ограниченных локальных ресурсов.

- Непрерывное обучение, позволяющее моделям постоянно усваивать новую информацию, поступающую на устройство, без необходимости полного переобучения и без потери ранее приобретенных знаний.

- Оптимизация моделей, включающая техники квантования (уменьшение точности представления данных), прунинга (удаление избыточных связей в нейронной сети) и дистилляции знаний (передача знаний от большой модели к меньшей). Эти методы значительно сокращают размер и вычислительную сложность моделей, делая их пригодными для периферийных устройств.

Внедрение обучения на конечном устройстве открывает широкие перспективы для развертывания интеллектуальных систем в самых разнообразных сферах, от потребительской электроники до промышленного интернета вещей, где постоянное сетевое подключение не всегда возможно или желательно. Оно обеспечивает создание по-настоящему автономных, адаптивных и конфиденциальных решений, которые способны самостоятельно развиваться и функционировать, расширяя границы применения искусственного интеллекта.

3.2. Перенос обучения и адаптация

Перенос обучения представляет собой фундаментальный подход в машинном обучении, позволяющий использовать знания, полученные моделью при решении одной задачи, для ускоренного и более эффективного обучения при решении другой, связанной задачи. Этот метод особенно важен для систем, функционирующих автономно, без постоянного подключения к сети.

Для малогабаритных ИИ-систем, предназначенных для работы на периферийных устройствах с ограниченными вычислительными ресурсами и памятью, перенос обучения становится не просто опцией, а необходимостью. Традиционное обучение моделей с нуля требует обширных наборов данных и значительных вычислительных мощностей, что часто недоступно для целевых устройств. Предварительно обученные на масштабных датасетах модели уже содержат богатый набор признаков и паттернов, которые могут быть адаптированы к новым, специфическим задачам.

Существует два основных метода применения переноса обучения. Первый - использование предварительно обученной модели как экстрактора признаков. В этом случае слои модели, отвечающие за извлечение высокоуровневых признаков, фиксируются, и обучается только новый, относительно небольшой классификатор или регрессор, который обрабатывает эти извлеченные признаки. Это значительно уменьшает объем вычислений и требуемых данных для дообучения.

Второй метод - тонкая настройка (fine-tuning). Он предполагает корректировку весов одного или нескольких последних слоев предварительно обученной модели, а иногда и всех слоев, на новом целевом наборе данных с небольшой скоростью обучения. Этот подход обеспечивает более высокую точность, поскольку модель адаптируется к нюансам новой задачи, но требует больше ресурсов по сравнению с простым извлечением признаков.

При адаптации к ограничениям малогабаритных систем возникает ряд специфических задач. Исходные предварительно обученные модели зачастую имеют избыточный размер. Для их эффективного использования на целевых устройствах применяются методы сжатия моделей, такие как квантование, при котором точность представлений весов и активаций снижается, и прореживание, удаляющее наименее значимые связи. Эти операции могут быть выполнены как до, так и после переноса обучения.

Особое внимание уделяется дистилляции знаний. Этот процесс позволяет передать функциональность большой, производительной модели-«учителя» в значительно меньшую модель-«ученика». Модель-ученик обучается воспроизводить выходы и/или внутренние представления учителя, что позволяет ей достигать сравнимой производительности при существенно меньшем размере и вычислительных затратах. Это критически важно для развертывания компактных ИИ на устройствах без доступа к сети.

Эффективное применение переноса обучения минимизирует потребность в больших специализированных наборах данных для каждой новой задачи, что является частой проблемой при разработке автономных систем. Это позволяет быстро развертывать ИИ-решения для конкретных сценариев, обеспечивая их работу непосредственно на устройстве пользователя, без зависимости от облачных сервисов или сетевого подключения.

3.3. Обновление и мониторинг систем

Даже самые автономные и изолированные искусственные интеллектуальные системы требуют непрерывного внимания к их актуальности и работоспособности. Способность функционировать без постоянного подключения к глобальной сети не снимает необходимости в адаптации к изменяющимся условиям, устранении выявленных недочетов или повышении общей эффективности. Поэтому обновление и мониторинг являются фундаментальными аспектами их жизненного цикла.

Основная сложность в реализации этих процессов для автономных систем заключается в отсутствии прямого доступа к интернету. Методы доставки обновлений должны быть тщательно продуманы и часто включают:

- Использование физических интерфейсов, таких как USB, специализированные порты или съемные носители данных.

- Применение локальных беспроводных протоколов, таких как Bluetooth Low Energy или Wi-Fi Direct, если это предусмотрено архитектурой и не противоречит концепции полной автономности от внешних сетей.

- Разработку механизмов, позволяющих загружать, верифицировать и безопасно устанавливать пакеты обновлений, обеспечивая их целостность и подлинность.

Ограниченные вычислительные ресурсы и объем памяти, характерные для "крошечных" ИИ, диктуют строгие требования к размеру и процедуре обновлений. Приоритет отдается дельта-обновлениям, которые передают только измененные части кода, минимизируя объем передаваемых данных и время установки. Критически важно предусмотреть атомарность процесса обновления, гарантируя, что система либо успешно перейдет на новую версию, либо полностью сохранит работоспособность предыдущей, исключая промежуточные нестабильные состояния. Механизмы отката (rollback) являются обязательным элементом для восстановления функциональности в случае неудачной установки или возникновения непредвиденных проблем.

Мониторинг жизненно важен для поддержания стабильной работы и сбора данных, необходимых для последующих усовершенствований. Без непрерывного сетевого соединения подход к мониторингу должен быть адаптирован:

- Локальная диагностика: Система должна самостоятельно отслеживать ключевые параметры производительности, такие как загрузка процессора, использование памяти, энергопотребление и точность выполнения задач.

- Регистрация событий: Важные системные события, ошибки, аномалии в поведении и показатели окружающей среды должны записываться в энергонезависимую память для последующего анализа.

- Механизмы выгрузки данных: Для извлечения собранных диагностических данных необходимо предусмотреть аналогичные методы, используемые для обновлений - физические подключения или локальные беспроводные каналы, позволяющие периодически собирать информацию.

Безопасность процессов обновления и мониторинга имеет первостепенное значение. Криптографическая подпись обновлений, защищенная загрузка и строгие протоколы аутентификации обеспечивают защиту от несанкционированного вмешательства, установки вредоносного программного обеспечения или компрометации данных. Долгосрочная жизнеспособность автономных ИИ-систем напрямую зависит от способности разработчиков эффективно поддерживать их на протяжении всего жизненного цикла, обеспечивая актуальность и надежность функционала без привязки к глобальной сетевой инфраструктуре.

4. Сферы практического применения

4.1. Устройства Интернета вещей

Устройства Интернета вещей (IoT) - это неотъемлемый компонент современной цифровой среды, обеспечивающий сбор и передачу данных между физическими объектами и информационными системами. В основе их функционирования лежит способность взаимодействовать с окружающим миром через различные датчики и исполнительные механизмы. Если мы говорим о «крошечном» ИИ, который работает автономно, то эти устройства становятся особенно значимыми.

Типичные устройства IoT включают в себя:

- Сенсоры (температуры, влажности, освещенности, давления, движения и так далее.), которые собирают информацию об окружающей среде.

- Микроконтроллеры или микропроцессоры, обрабатывающие полученные данные.

- Модули связи (Wi-Fi, Bluetooth, Zigbee, LoRaWAN, NB-IoT), позволяющие передавать данные.

- Исполнительные механизмы (реле, моторы, светодиоды), которые могут изменять состояние объекта или среды в ответ на команды.

Для работы без подключения к интернету, устройства IoT должны обладать достаточной вычислительной мощностью и памятью для локальной обработки данных и выполнения алгоритмов ИИ. Это означает, что «крошечные» ИИ-модели должны быть оптимизированы для минимального потребления ресурсов. Например, в умном доме датчик движения может не просто фиксировать присутствие человека, но и, используя встроенный ИИ, определять его намерения или даже идентифицировать личность, не отправляя при этом данные в облако. Такой подход повышает конфиденциальность и снижает задержки в принятии решений.

Примеры таких автономных устройств включают:

- Носимые устройства для мониторинга здоровья, которые анализируют пульс, активность и сон, выдавая рекомендации без постоянной синхронизации с сервером.

- Промышленные датчики, способные выявлять аномалии в работе оборудования и прогнозировать отказы, не требуя сетевого подключения для каждого измерения.

- Умные сельскохозяйственные сенсоры, которые анализируют состояние почвы и растений, оптимизируя полив и удобрения на основе локальных данных.

Эффективность таких решений напрямую зависит от способности ИИ-моделей работать с ограниченными ресурсами и обеспечивать высокую точность принятия решений. Это требует глубокой оптимизации алгоритмов, использования специализированных аппаратных ускорителей и тщательного проектирования всей системы, чтобы устройства IoT могли функционировать как полноценные автономные узлы интеллектуальной сети.

4.2. Носимая электроника

Носимая электроника представляет собой один из наиболее динамично развивающихся сегментов рынка, проникающий в повседневную жизнь миллиардов людей. Умные часы, фитнес-трекеры, медицинские сенсоры и даже элементы умной одежды - все эти устройства объединяет одно: их непосредственная близость к пользователю и сбор персонализированных данных. Однако истинный потенциал носимых гаджетов раскрывается лишь при условии их способности к автономному анализу информации.

Для эффективной работы таких устройств критически важна возможность обработки данных непосредственно на борту, без постоянной зависимости от облачных сервисов. Это обусловлено несколькими факторами. Во-первых, ограничения по энергопотреблению и вычислительной мощности требуют максимально оптимизированных алгоритмов. Во-вторых, вопросы конфиденциальности пользовательских данных диктуют необходимость минимизации их передачи во внешние сети. В-третьих, мгновенная реакция на изменения состояния пользователя или окружающей среды не допускает задержек, связанных с сетевой передачей.

Именно здесь концепция компактных моделей искусственного интеллекта, способных функционировать в условиях ограниченных ресурсов и без сетевого подключения, приобретает особую значимость. Такие решения позволяют реализовать сложные аналитические функции прямо на устройстве. Это включает в себя непрерывный мониторинг физиологических показателей с обнаружением аномалий, распознавание речевых команд и жестов, адаптивное управление энергопотреблением и даже персонализированные рекомендации, основанные на поведенческих паттернах.

Преимущества такого подхода очевидны. Пользователи получают устройства, которые работают надежно в любых условиях, будь то отсутствие интернета или низкое качество связи. Их личные данные остаются защищенными, поскольку не покидают устройство для обработки. А производители могут создавать инновационные продукты с высокой степенью автономности и функциональности. Например, медицинские носимые устройства могут в реальном времени анализировать ЭКГ для выявления аритмий, а фитнес-трекеры - с высокой точностью определять тип активности и корректировать тренировочные программы, не требуя синхронизации с сервером.

Развитие технологий миниатюрных нейронных сетей и специализированных аппаратных ускорителей открывает новые горизонты для носимой электроники. Мы стоим на пороге эры, когда наши гаджеты станут не просто сборщиками данных, а полноценными интеллектуальными компаньонами, способными принимать решения и адаптироваться к нашим потребностям, сохраняя при этом приватность и автономность. Это требует дальнейших исследований в области оптимизации алгоритмов, разработки сверхэффективных чипов и создания новых методов обучения ИИ, способных работать с ограниченными наборами данных непосредственно на периферии.

4.3. Промышленная автоматизация

Промышленная автоматизация - это краеугольный камень современной индустрии, обеспечивающий беспрецедентную эффективность, точность и безопасность производственных процессов. Она охватывает широкий спектр технологий, от простых механизмов управления до сложных роботизированных комплексов, направленных на минимизацию человеческого участия и оптимизацию операций. Традиционные подходы часто опираются на централизованные системы и облачные вычисления, что может создавать уязвимости, связанные с задержками передачи данных, зависимостью от сетевой инфраструктуры и вопросами кибербезопасности. Однако будущее промышленной автоматизации неразрывно связано с развитием автономных интеллектуальных систем, способных принимать решения непосредственно на месте сбора данных.

Такие локальные ИИ-системы, функционирующие без постоянного подключения к внешним сетям, обеспечивают ряд критически важных преимуществ для промышленных предприятий. Они существенно сокращают задержки, позволяя осуществлять обработку данных и реагирование в реальном времени, что неоценимо для высокоскоростных производственных линий и систем безопасности. Кроме того, обработка данных непосредственно на устройстве или в цехе значительно повышает конфиденциальность и устойчивость к внешним кибератакам, поскольку чувствительная информация не покидает контролируемую среду. Это также снижает нагрузку на сетевую инфраструктуру и потребность в широкополосном интернете, что особенно актуально для удаленных или труднодоступных объектов.

Применение подобных автономных интеллектуальных решений в промышленной автоматизации охватывает множество областей. Среди них:

- Предиктивное обслуживание оборудования: анализ вибрации, температуры и других параметров непосредственно на станке для прогнозирования потенциальных отказов и планирования технического обслуживания, минимизируя простои.

- Контроль качества продукции: встроенные системы машинного зрения, способные в реальном времени выявлять дефекты и отклонения от стандартов на производственной линии.

- Оптимизация производственных процессов: динамическая настройка параметров работы машин и оборудования на основе локальных данных для повышения производительности и снижения энергопотребления.

- Автономная робототехника: оснащение роботов возможностью принимать сложные решения и адаптироваться к изменяющимся условиям среды без постоянного контроля извне.

- Мониторинг безопасности: обнаружение аномалий и потенциально опасных ситуаций в рабочей зоне с мгновенным оповещением или автоматическим прекращением работы.

Внедрение этих передовых технологий ведет к созданию более гибких, надежных и экономически эффективных производственных систем. Промышленные предприятия получают возможность значительно повысить операционную эффективность, сократить эксплуатационные расходы и обеспечить новый уровень безопасности. Это стратегическое направление развития, определяющее конкурентоспособность и устойчивость современного производства в условиях динамично меняющегося мира.

4.4. Медицинское оборудование

Медицинское оборудование является краеугольным камнем современной системы здравоохранения, постоянно эволюционируя для обеспечения более точной диагностики, эффективного лечения и улучшенного мониторинга состояния пациентов. Сегодня мы наблюдаем трансформацию этой области благодаря интеграции передовых интеллектуальных систем, способных функционировать автономно, непосредственно на уровне устройства. Это открывает беспрецедентные возможности для повышения качества медицинских услуг, особенно в условиях, где традиционная сетевая инфраструктура либо недоступна, либо ненадежна.

Развитие компактных и высокоэффективных интеллектуальных алгоритмов, способных обрабатывать данные и принимать решения без зависимости от внешних серверов или облачных вычислений, кардинально меняет подходы к созданию медицинских приборов. Такие решения позволяют выполнять сложный анализ данных в реальном времени непосредственно на месте их сбора, будь то портативный диагностический аппарат, носимое устройство для мониторинга или роботизированная хирургическая система. Это критически важно для обеспечения оперативной реакции на изменения в состоянии пациента и для сохранения конфиденциальности чувствительной медицинской информации, поскольку данные не покидают устройство.

Подобные автономные интеллектуальные системы находят применение в широком спектре медицинского оборудования:

- Диагностические устройства: от ультразвуковых аппаратов с встроенной аналитикой для выявления патологий до портативных электрокардиографов, способных мгновенно интерпретировать сердечные ритмы и предупреждать о нарушениях.

- Носимые и имплантируемые сенсоры: устройства для непрерывного мониторинга уровня глюкозы, артериального давления, параметров сна или двигательной активности, которые могут локально анализировать данные и выдавать предупреждения или рекомендации без постоянного подключения к сети.

- Терапевтические системы: интеллектуальные инсулиновые помпы, регулирующие дозировку на основе данных о состоянии пациента, или реабилитационные тренажеры, адаптирующие программу упражнений в зависимости от прогресса, определенного на устройстве.

- Хирургическая робототехника: системы, способные осуществлять автономные функции или предоставлять улучшенную навигацию и обратную связь хирургам, полагаясь на локальную обработку изображений и данных.

Преимущества такой архитектуры многочисленны. Во-первых, значительно повышается надежность систем, поскольку их работа не зависит от стабильности интернет-соединения, что особенно актуально для экстренной медицины или использования в отдаленных районах. Во-вторых, скорость обработки данных увеличивается многократно, позволяя принимать решения в миллисекундах - это критично для устройств жизнеобеспечения и хирургических инструментов. В-третьих, локальная обработка данных усиливает защиту конфиденциальной информации пациента, минимизируя риски несанкционированного доступа при передаче по сети. Кроме того, снижение энергопотребления таких систем способствует созданию более компактных и долговечных портативных устройств, расширяя возможности дистанционного мониторинга и диагностики.

Несмотря на значительные успехи, дальнейшее развитие автономных интеллектуальных систем в медицинском оборудовании требует непрерывных исследований в области оптимизации алгоритмов, миниатюризации аппаратных компонентов и обеспечения строгих стандартов безопасности и точности. Перспективы применения этой технологии колоссальны: от персонализированной медицины, где каждый прибор адаптируется под индивидуальные нужды пациента, до значительного расширения доступности высокотехнологичной медицинской помощи по всему миру. Это направление является одним из наиболее перспективных для будущего здравоохранения.

4.5. Системы умного дома

4.5. Системы умного дома представляют собой одну из наиболее перспективных областей применения автономных ИИ-систем. Здесь мы говорим о решениях, которые функционируют полностью локально, не требуя постоянного подключения к облачным сервисам или интернету. Это критически важно для обеспечения приватности, безопасности и надежности, особенно когда речь идет об управлении критически важными функциями жилища.

Представьте себе систему, способную адаптироваться к вашим предпочтениям в освещении, температуре или даже в выборе музыкального фона, основываясь на анализе ваших ежедневных привычек, без отправки этих данных на удаленные серверы. Такие «крошечные» ИИ могут быть встроены непосредственно в устройства - от умных термостатов и осветительных приборов до систем безопасности и бытовой техники. Их способность к обучению и принятию решений на месте обеспечивает мгновенный отклик и минимизирует задержки, что особенно ценно для комфорта и безопасности.

Примеры конкретных применений включают:

- Автоматическое управление климатом: ИИ изучает ваши предпочтения и погодные условия, регулируя отопление и кондиционирование для оптимального комфорта и энергоэффективности, не передавая данные о вашем присутствии или отсутствии за пределы дома.

- Системы безопасности: локальный ИИ может анализировать видеопотоки с камер наблюдения, распознавать аномалии (например, незнакомые лица или необычные движения) и принимать решения об оповещении или активации сигнализации, не отправляя конфиденциальные изображения в облако.

- Управление освещением: ИИ адаптирует интенсивность и цвет света в зависимости от времени суток, вашего настроения или активности, основываясь на данных, собранных исключительно внутри дома.

- Интеллектуальные помощники: голосовые ассистенты, которые обрабатывают команды и запросы локально, обеспечивая полную конфиденциальность ваших разговоров.

Такие системы повышают не только удобство, но и уровень безопасности данных, так как информация о вашей жизни не покидает пределов вашего дома. Они устойчивы к сбоям в интернет-соединении и менее уязвимы для кибератак, поскольку отсутствует внешний канал передачи конфиденциальных данных. Это фундаментально меняет подход к созданию умных домов, делая их по-настоящему автономными и ориентированными на пользователя.

5. Вызовы и направления развития

5.1. Энергоэффективность

Энергоэффективность является фундаментальным аспектом при создании автономных миниатюрных систем искусственного интеллекта. Способность таких систем функционировать без постоянного подключения к сети и с минимальным потреблением энергии определяет их применимость в широком спектре сценариев: от носимых устройств и промышленных датчиков до систем мониторинга в удаленных регионах. Ограниченные ресурсы питания, будь то батареи или маломощные источники энергии, диктуют строгие требования к оптимизации каждого цикла обработки данных.

Основная задача состоит в том, чтобы добиться высокопроизводительной обработки информации при крайне низком энергопотреблении. Традиционные модели ИИ, разработанные для облачных вычислений, зачастую требуют значительных вычислительных мощностей и объемов памяти, что делает их непригодными для устройств с жесткими энергетическими ограничениями. Следовательно, достижение энергоэффективности требует комплексного подхода, охватывающего как архитектуру моделей, так и аппаратные платформы.

Для минимизации потребления энергии применяются различные методы оптимизации моделей. Ключевым направлением здесь выступает квантование, которое уменьшает точность представления чисел (например, с 32-битных до 8-битных или даже бинарных), что значительно сокращает объем данных и вычислительные затраты. Другие методы включают прунинг (удаление избыточных связей или нейронов в сети), дистилляцию знаний (передача знаний от большой модели к меньшей) и факторизацию матриц с низким рангом. Эти подходы позволяют существенно уменьшить размер модели и количество операций, необходимых для инференса, тем самым снижая энергопотребление.

Помимо оптимизации программного обеспечения, критическое значение имеет аппаратная поддержка. Разработка специализированных ускорителей ИИ, таких как нейронные процессоры (NPU) или тензорные процессоры (TPU) для граничных вычислений, позволяет выполнять операции машинного обучения с гораздо большей эффективностью по сравнению с универсальными центральными или графическими процессорами. Эти специализированные чипы спроектированы для параллельной обработки данных и выполнения матричных операций, что значительно снижает потребление энергии на каждую операцию. Также исследуются новые вычислительные парадигмы, такие как нейроморфные вычисления, которые имитируют работу человеческого мозга и обладают потенциалом для достижения беспрецедентной энергоэффективности.

Энергоэффективность также достигается за счет оптимизации алгоритмов обработки данных на уровне сенсоров и устройств. Это включает:

- Минимизацию количества передаваемых данных.

- Выполнение предварительной обработки и фильтрации данных непосредственно на устройстве.

- Применение алгоритмов, которые позволяют системе «спать» большую часть времени и активироваться только при обнаружении значимых событий.

В конечном итоге, высокая энергоэффективность не просто продлевает срок службы батареи; она открывает двери для внедрения интеллектуальных функций в устройства, которые ранее были ограничены по своим возможностям из-за энергетических требований. Это обеспечивает более широкое распространение автономных систем ИИ, способных функционировать в самых разнообразных и сложных условиях без зависимости от внешней инфраструктуры.

5.2. Безопасность и конфиденциальность данных

Как эксперт в области передовых технологий, я могу утверждать, что аспекты безопасности и конфиденциальности данных приобретают фундаментальное значение при создании автономных систем искусственного интеллекта, функционирующих непосредственно на устройстве. В отличие от облачных решений, где данные постоянно перемещаются между пользовательскими устройствами и удаленными серверами, локальная обработка информации радикально меняет парадигму защиты.

Основное преимущество таких систем заключается в минимизации передачи данных. Поскольку ИИ-модель обрабатывает информацию непосредственно на устройстве, будь то смартфон, носимый гаджет или промышленный датчик, конфиденциальные сведения никогда не покидают его пределы. Это устраняет множество традиционных векторов атак, связанных с перехватом данных в процессе передачи или их хранением на сторонних серверах. Риски, ассоциируемые с централизованными хранилищами данных - такими как массовые утечки, компрометация облачных учетных записей или несанкционированный доступ к базам данных - существенно снижаются или полностью нивелируются. Пользователь получает беспрецедентный контроль над своими данными, поскольку они остаются исключительно в его владении.

Помимо снижения рисков, связанных с передачей и централизованным хранением, автономные ИИ-системы способствуют принципу минимизации данных. Зачастую для выполнения конкретной задачи такие модели требуют лишь небольшой объем специализированной информации, необходимой для локального анализа, а не обширные массивы персональных данных. Это сокращает объем потенциально уязвимой информации и, как следствие, снижает привлекательность системы для злоумышленников. Отсутствие постоянного подключения к интернету также уменьшает поверхность атаки, делая систему менее доступной для удаленных кибератак, таких как распределенные атаки типа «отказ в обслуживании» (DDoS) или попытки несанкционированного удаленного доступа.

Однако, несмотря на эти значительные преимущества, аспекты безопасности и конфиденциальности требуют тщательного подхода даже при локальной обработке. Необходимо обеспечить надежную защиту самой модели ИИ от несанкционированных изменений или реверс-инжиниринга, способного раскрыть внутренние алгоритмы или даже используемые данные. Это включает в себя применение криптографических методов для защиты кода и весов модели, а также механизмов безопасной загрузки и обновления прошивки. Кроме того, важно учитывать потенциальные побочные каналы утечки информации, такие как анализ энергопотребления или электромагнитного излучения устройства, которые могут быть использованы для извлечения конфиденциальных данных. Разработчики должны внедрять строгие политики контроля доступа к данным на самом устройстве, гарантируя, что даже если устройство будет скомпрометировано физически, доступ к чувствительной информации будет затруднен. Прозрачность в отношении того, какие данные обрабатываются локально и как они используются, также имеет первостепенное значение для поддержания доверия пользователей. Таким образом, хотя автономные ИИ-системы предлагают мощный фундамент для повышения безопасности и конфиденциальности, их полная реализация требует комплексного подхода, охватывающего все этапы жизненного цикла устройства и программного обеспечения.

5.3. Масштабирование производства

Масштабирование производства передовых автономных интеллектуальных систем представляет собой стратегический императив для перехода от концептуальных разработок к повсеместному внедрению. Этот процесс охватывает весь жизненный цикл продукта, начиная от выбора компонентов и заканчивая логистикой, и требует глубокого понимания специфики устройств, функционирующих без постоянного сетевого соединения.

Основной вызов на этапе масштабирования заключается в обеспечении стабильного и экономически эффективного производства специализированных аппаратных платформ. Речь идет о компонентах, разработанных для минимального энергопотребления и высокой производительности при ограниченных вычислительных ресурсах, таких как специализированные микроконтроллеры или нейронные процессоры для периферийных вычислений. Надежность поставок этих высокотехнологичных элементов, зачастую уникальных или производимых ограниченным числом поставщиков, определяет темпы и объемы производства. Помимо доступности, критически важной является их бесшовная интеграция в конечные устройства, что требует прецизионной сборки и контроля качества на каждом этапе.

Развертывание программного обеспечения на тысячи и миллионы устройств, функционирующих автономно, порождает отдельный комплекс задач. Необходима разработка унифицированных и надежных механизмов прошивки, способных эффективно загружать и верифицировать модели. Оптимизация программного кода для работы в условиях жестких ограничений по памяти и производительности, а также обеспечение кибербезопасности автономных систем, являются приоритетными направлениями. Масштабное функциональное тестирование каждого произведенного экземпляра на соответствие заданным параметрам производительности, надежности и безопасности требует внедрения высокоавтоматизированных тестовых стендов и строгих протоколов контроля. Ручное тестирование становится невозможным при достижении промышленных объемов.

Управление глобальными цепочками поставок для обеспечения непрерывности производства, снижение логистических рисков и оптимизация себестоимости продукции при наращивании объемов - это постоянные задачи. Достижение эффекта масштаба без компромиссов в отношении качества является одной из ключевых целей, требующей постоянного анализа и совершенствования производственных процессов.

Для успешного масштабирования производства автономных интеллектуальных систем применяются следующие подходы:

- Стандартизация аппаратных платформ и программных интерфейсов. Это позволяет унифицировать производственные линии, сократить время на разработку и тестирование новых модификаций.

- Максимальная автоматизация процессов сборки, тестирования и калибровки. Использование роботизированных систем и автоматизированных систем технического зрения значительно повышает точность, скорость и повторяемость операций, минимизируя влияние человеческого фактора.

- Внедрение модульной архитектуры как для аппаратной части, так и для программного обеспечения. Модульность упрощает сборку, облегчает диагностику и обслуживание, а также позволяет быстрее адаптироваться к изменениям требований или новым технологиям.

- Формирование стратегических партнерств с ведущими производителями специализированных компонентов и контрактными производителями. Это обеспечивает доступ к передовым технологиям, гарантирует объемы поставок и способствует снижению производственных затрат.

- Разработка и применение специализированных инструментов для массовой прошивки, конфигурации и контроля качества устройств. Эти инструменты должны быть интегрированы в общую систему управления производством.

- Постоянное совершенствование производственных процессов на основе данных и обратной связи. Методологии бережливого производства и непрерывного улучшения позволяют выявлять узкие места и повышать общую эффективность.

Внедрение этих принципов позволяет не только нарастить объемы производства, но и поддерживать высокий уровень качества продукции, что критически важно для систем, функционирующих в автономном режиме и зачастую в удаленных или труднодоступных местах.

5.4. Будущее автономных интеллектуальных систем

Эволюция автономных интеллектуальных систем представляет собой трансформационную траекторию для технологии и общества. Мы являемся свидетелями глубокого сдвига от централизованного, зависимого от облачных вычислений искусственного интеллекта к парадигме, где передовые аналитические возможности все чаще встраиваются непосредственно в устройства и датчики. Эта децентрализация не просто архитектурное изменение; она означает фундаментальное переопределение того, как интеллект взаимодействует с физическим миром, обещая беспрецедентные уровни отзывчивости, конфиденциальности и устойчивости.

Центральным аспектом этого будущего становится способность интеллектуальных систем функционировать автономно, без постоянного обращения к удаленным серверам или облачным платформам. Это достигается за счет разработки высокоэффективных алгоритмов и оптимизированных нейронных сетей, которые могут обрабатывать данные и принимать решения непосредственно на уровне конечного устройства. Такой подход имеет определяющее значение для целого ряда критически важных применений, где задержка передачи данных недопустима, а конфиденциальность информации имеет первостепенное значение.

Преимущества локализованной обработки данных многочисленны. Во-первых, значительно повышается конфиденциальность, поскольку чувствительная информация не покидает устройство пользователя или локальную сеть. Во-вторых, сокращается задержка, что критично для систем реального времени, таких как автономный транспорт, медицинское оборудование или промышленные контроллеры. В-третьих, существенно возрастает надежность: системы сохраняют полную работоспособность даже в условиях отсутствия или нестабильности сетевого соединения. Кроме того, снижается энергопотребление и общая нагрузка на сетевую инфраструктуру, что способствует более устойчивому развитию цифровых экосистем.

Потенциал применения таких автономных систем обширен и охватывает практически все сферы человеческой деятельности. Они будут интегрированы в умные дома, обеспечивая персонализированные и безопасные сценарии взаимодействия без передачи данных во внешние облака. В промышленности это позволит развернуть интеллектуальные датчики и исполнительные механизмы, способные к предиктивной аналитике и оптимизации процессов на месте, повышая эффективность и безопасность производственных циклов. Носимые устройства смогут предоставлять мгновенную обратную связь и анализ состояния здоровья, сохраняя при этом приватность пользовательских данных. В логистике и сельском хозяйстве автономные роботы и дроны смогут действовать независимо, адаптируясь к изменяющимся условиям среды.

Однако, развитие этого направления сопряжено с рядом вызовов. Необходимо обеспечить высочайший уровень кибербезопасности для каждого интеллектуального узла, предотвращая несанкционированный доступ и манипуляции. Требуется разработка унифицированных стандартов и протоколов для обеспечения совместимости и масштабируемости таких децентрализованных систем. Вопросы этики и ответственности за автономные решения, особенно в критически важных областях, требуют тщательной проработки на законодательном и общественном уровнях. Наконец, непрерывные исследования в области уменьшения вычислительных требований, повышения энергоэффективности и способности к обучению на ограниченных данных остаются приоритетными для реализации полного потенциала этих технологий.

В перспективе, автономные интеллектуальные системы станут неотъемлемой частью нашей среды, формируя повсеместную интеллектуальную инфраструктуру, которая будет адаптироваться, обучаться и взаимодействовать с миром с беспрецедентной эффективностью и самостоятельностью. Это открывает путь к созданию по-настоящему умных городов, адаптивных производств и персонализированных услуг, где интеллект не ограничен рамками централизованных серверов, а присутствует везде, где это необходимо. Это будет эра глубоко интегрированного и распределенного интеллекта, преобразующего наше взаимодействие с технологиями и окружающим миром.